22 Jahre lang keine globale Erwärmung - ein neuer Rekord - Die Pause wurde inzwischen zur globalen Abkühlung.

Die Pause verlängert sich noch einmal. Ein Drittel des gesamten Einflusses des Menschen auf das Klima seit der industriellen Revolution ist seit Februar 1997 entstanden, als der Hype richtig Fahrt aufnahm. Doch die 268 Monate seit damals zeigen keinerlei globale Erwärmung. Mit der Temperaturaufzeichnung des RSS (Remote Sensing Systems satellite) ist in den Weltmeeren eine leichte, aber deutliche Abkühlung seit 2004 bis 2018 nachweisbar. Mehr dazu weiter unten im Artikel. Auch Satellitendaten und Bodenmessstations Daten beweisen eine deutliche Abkühlung.

22 Jahre 4 Monate lang keine globale Erwärmung - mit der seit 2015 eingesetzten Abkühlung ein neuer Rekord

Von Christopher Monckton von Brenchley

Aktualisiert von R. Funk

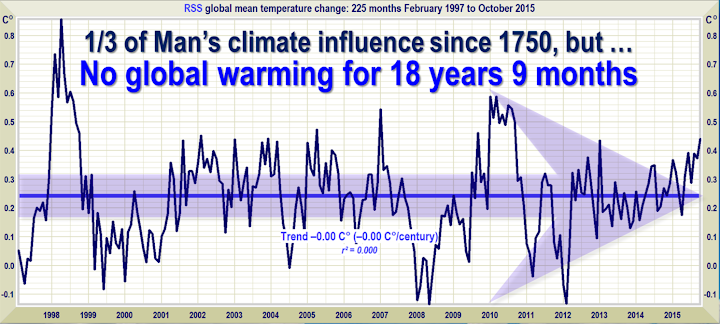

Während sich die Gläubigen um ihre umzingelten Schamanen in Paris zum jährlichen Gottesdienstfest des Neuen Aberglaubens versammeln, verlängert sich die Pause weiterhin. Ein Drittel des gesamten Einflusses des Menschen auf das Klima seit der industriellen Revolution begann seit Februar 1997. Doch in den 268 Monaten seit diesem Zeitpunkt zeigt sich keine globale Erwärmung (Abb. 1). Mit dem RSS-Temperaturrekord dieses Monats schlägt die Pause den Rekord des letzten Monats und liegt nun bei 22 Jahren und 4 Monaten.

Abbildung 1. Der lineare Regressionstrend der kleinsten Quadrate auf dem monatlichen Datensatz der globalen mittleren Oberflächentemperatur des RSS-Satelliten zeigt seit Februar 1997 seit 22 Jahren 9 Monate keine globale Erwärmung, obwohl ein Drittel aller anthropogenen Forcierungen während der Zeit der Pause stattgefunden hat.

Der zufällige Delegierte aus Burma provozierte während der letzten Segnung in Doha vor drei Jahren Wutanfälle bei der Gemeinde, als er sagte, dass die Pause 16 Jahre lang andauert. Jetzt, fast sieben Jahre später, ist die Pause fast sieben Jahre länger.

Es lohnt sich zu verstehen, wie überrascht die Modellierer von der Beharrlichkeit der Pause sein sollten. NOAA, in einem sehr seltenen Anfall von Ehrlichkeit, gab in ihrem State of the Climate Report 2008 zu, dass 15 Jahre oder mehr ohne globale Erwärmung eine Diskrepanz zwischen Vorhersage und Beobachtung aufweisen würden. Der Grund für die Aussage der NOAA ist, dass es eine scharfe und signifikante sofortige Reaktion auf einen Strahlungsantrieb wie die Zugabe von CO2 in die Luft geben soll.

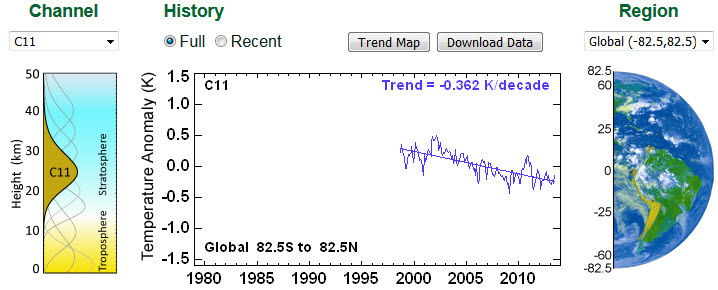

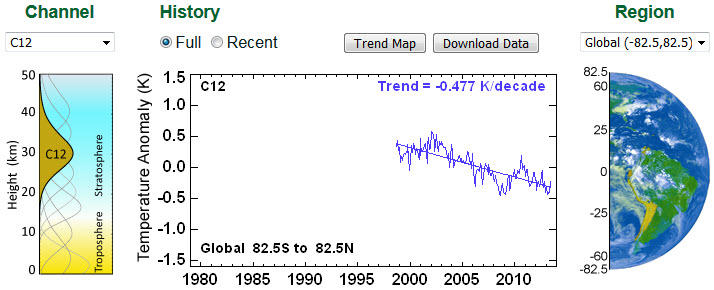

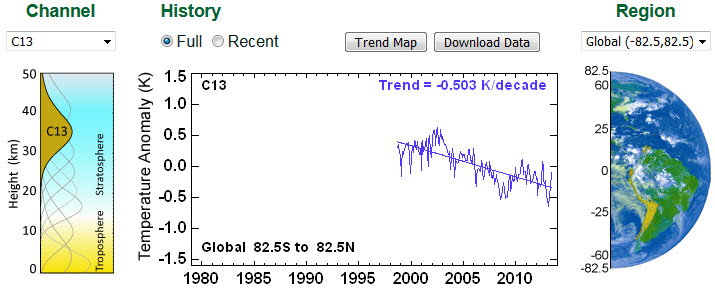

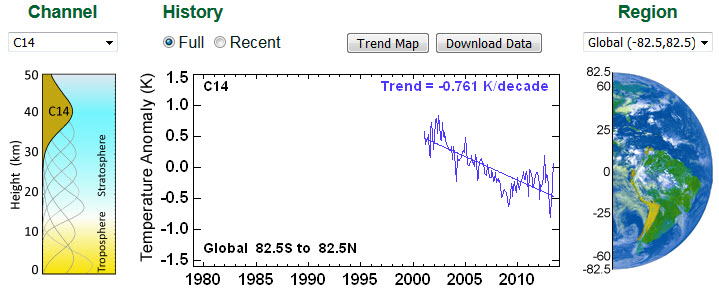

RSS Satellitendaten Historisch bis Heute

Betrachten wir die aktuellen MSU (Microwave Sounding Unit) and AMSU (Advanced Microwave Sounding Unit) RSS Daten aktualisiert auf den Stand von Heute, ist eine globale Abkühlung nachweisbar. (Dieser Artikel wurde ursprünglich 2015 erstellt.)

Die MSU & AMSU Time Series basieren auf den RSS Satellitendaten. Verschiedene Satelliten überwachen dabei die Erdatmosphäre und zeichnen die Daten auf. Nachfolgend die globale Entwicklung in verschiedenen atmosphärischen Höhenlagen und in unterschiedlichen hemisphärischen Aufteilungen.

Zuerst die globalen Temperaturentwicklungen in unterschiedlichen Höhen.

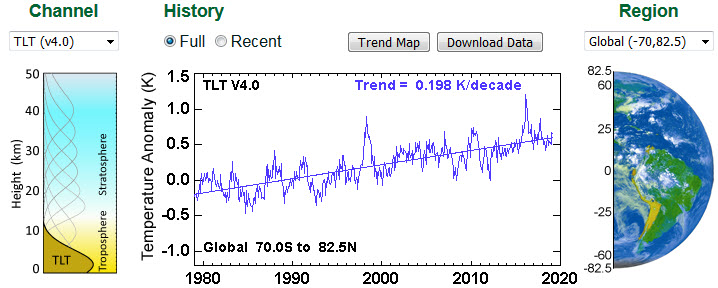

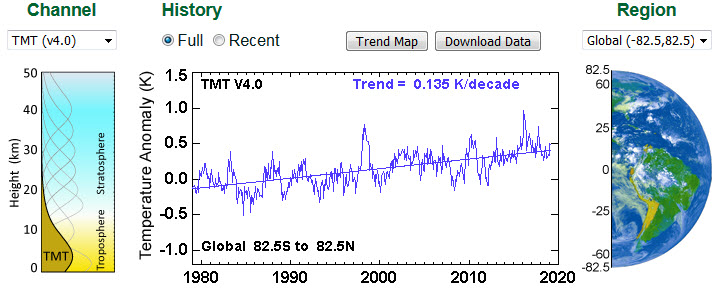

| Links Kanal TLT (Troposphäre Lower Temperatur). Temperaturverlauf in einer Höhe zwischen 0 - 10 Km. Seit 1980 bis 2012 im Mittel eine Erwärmung um ca. 0.75 K. Zwischen 2012 und 2019 im Mittel eine Abkühlung um ca. 0.25 K. Links Kanal TMT (Troposphärische Mittel Temperatur). Temperaturverlauf in einer Höhe zwischen 0 - 20 Km. Seit 1980 bis 2012 im Mittel eine Erwärmung um ca. 0.5 K. Zwischen 2012 und 2019 im Mittel eine Abkühlung um ca. 0.2 K.

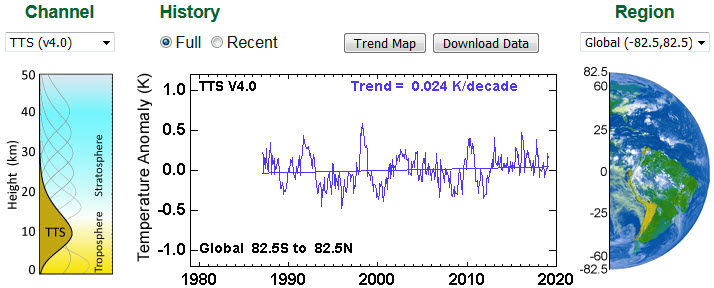

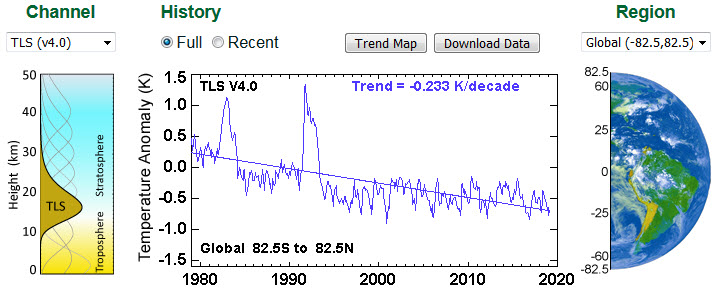

Leider sind C11 Daten der Stratosphäre erst seit 1998 verfügbar. Zeigen jedoch eindrücklich die drastische Abkühlung in der mittleren Stratosphäre. Im obersten Bereich der Stratosphäre wurde eine noch dramatischere Abkühlung zwischen 1998 bis 2013 festgestellt. Mit -0.761 K pro Dekade ein regelrechter Temperatursturz, der sich längerfristig durch die langsame Abkühlung der Ozeane, auch auf die untere Troposphäre auswirken wird. |

Die Steilheit dieser vorhergesagten Reaktion ist in Abb. 1a zu sehen, die auf einem Papier über Temperaturrückwirkungen von Professor Richard Lindzens ehemaligem Schüler Professor Gerard Roe im Jahr 2009 basiert. Das Diagramm der Modellausgabe von Roe zeigt, dass die anfänglich erwartete Reaktion auf ein Forcen eine sofortige und schnelle Erwärmung sein soll. Aber trotz der sehr erheblichen Zwangsmaßnahmen in den 22 Jahren und 4 Monaten seit Februar 1997 hat es kein Flackern der Erwärmung gegeben.

Abbildung 1a: Modelle prognostizieren eine schnelle anfängliche Erwärmung als Reaktion auf einen Zwang. Stattdessen findet überhaupt keine Erwärmung statt. Basierend auf Roe (2009).

Bei den Ereignissen Heartland und Philip Foster in Paris werde ich im Detail auf die drei schwerwiegenden Fehler eingehen, die dazu geführt haben, dass die Modelle die Erwärmung so stark überbewertet haben.

Der aktuelle el Niño, wie Bob Tisdales ausgezeichnete Berichtsreihe hier zeigt, ist mindestens so groß wie der Great el Niño von 1998. Die RSS-Temperaturaufzeichnung beginnt, ihre Größe zu reflektieren.

Die Auszeit von 22 Jahren 4 Monaten ist der weiteste Zeitraum, den man im RSS-Satelliten-Temperaturprotokoll zurücklegen kann und zeigt immer noch einen Trend unter Null. Das Startdatum ist nicht kirschrot gepickt, sondern wird berechnet.

Und ja, das Startdatum für die Pause hat sich vorwärts bewegt, wenn auch nur etwas langsamer als das Enddatum, weshalb die Pause im Durchschnitt weiter verlängert wird.

Solange eine Stagnation der globalen Temperatur einfach nicht nur mit den extremistischen Vorhersagen der Computermodelle übereinstimmt, sondern auch mit der Panik, die von den rentensuchenden Profitmachern des Untergangs ausgelöst wird, die sich in Paris die Hände mit Freude reiben.

Der UAH-Datensatz zeigt eine Pause, die fast so lang ist wie der RSS-Datensatz. Die stark veränderten Datensätze der Oberflächen-Tamperatur zeigen jedoch eine geringe Erwärmungsrate (Abb. 1b). (Die HadCRUT4 Daten wurden nachträglich so abgeändert, dass eine drastische Erwärmung entstand!

Aufdeckung der Datenverfälschung zugunsten einer angeblichen Erwärmung!

Abbildung 1b. Der lineare Regressionstrend der kleinsten Quadrate auf dem Mittelwert der terrestrischen monatlichen globalen Oberflächenmitteltemperaturanomalie-Datensätze GISS, HadCRUT4 und NCDC zeigt die globale Erwärmung mit einer Rate von 1,1 C° pro Jahrhundert während des Zeitraums der Pause von Januar 1997 bis September 2015.

Unter Berücksichtigung der Tatsache, dass ein Drittel der 2,4 W m-2 strahlenden Strahlung, die seit 1750 aus allen künstlichen Quellen stammt, während der Zeit der Pause auftrat, ist eine Erwärmungsrate, die etwas mehr als 1 C°/Jahrhundert entspricht, nicht gerade alarmierend.

Wie immer, ein Hinweis zur Vorsicht. Lediglich weil es in den letzten Jahrzehnten wenig oder gar keine Erwärmung gegeben hat, darf man nicht den Schluss ziehen, wie sich die Abkühlung in den letzten 12 Jahren weiterverlaufen wird. Die Trendlinien messen, was passiert ist: Sie sagen nicht voraus, was passieren wird.

Die Pause - politisch nützlich, so nützlich sie auch für alle sein mag, die sich wünschen, dass sich die "offizielle" Wissenschaftsgemeinschaft an ihre Pflicht zur Skepsis erinnert - ist weit weniger wichtig als die wachsende Diskrepanz zwischen den Vorhersagen der Modelle der allgemeinen Zirkulation und der beobachteten Realität.

Die Diskrepanz zwischen den Prognosen der Modelle von 1990 (Abb. 2) und 2005 (Abb. 3) einerseits und dem beobachteten Ergebnis andererseits nimmt weiter zu. Die Pause hat sich seit der Erstellung dieses Artikels im Jahr 2015 um 4 Jahre verlängert und hat inzwischen zu einer drastischen globalen Abkühlung gedreht. Die Erwärmungsrate im Vierteljahrhundert seit dem ersten Bewertungsbericht des IPCC im Jahr 1990 ist damit unter 1 C°/Jahrhundert Erwärmung seit 1860 gesunken.

Abbildung 2. Kurzfristige Prognosen der Erwärmung mit einer Rate, die 2,8[1,9, 4,2] K/Jahrhundert entspricht, die mit "erheblichem Vertrauen" in das IPCC (1990) für die 309 Monate Januar 1990 bis September 2015 (orangefarbene Region und rote Trendlinie) erstellt wurden, vs. beobachtete Anomalien (dunkelblau) und Trends (hellblau) bei nur 1,02 K/Jahrhundert Äquivalent, gemessen als Mittelwert der RSS- und UAH v.6-Satellitenmonatsmittelwerte der Temperaturanomalien mit niedrigerer Troposphäre.

Abbildung 3. Voraussichtliche Temperaturänderung, Januar 2005 bis September 2015, mit einer Rate, die 1,7[1,0, 2,3] Cº/Jahrhundert (orangefarbene Zone mit dicker roter Best-Estimate-Trendlinie) entspricht, verglichen mit den nahezu Null beobachteten Anomalien (dunkelblau) und dem realen Welttrend (hellblau), gemessen als Mittelwert der RSS- und UAH v.6-Satelliten-Temperaturanomalien mit niedrigerer Troposphäre.

Wie immer erläutert die Technische Mitteilung die Quellen der Vorhersagen des IPCC aus den Jahren 1990 und 2005 und zeigt auch, dass sich die Ozeane nach den Bathythermographen-Daten von ARGO mit einer Geschwindigkeit erwärmen, die weniger als einem Viertel Grad Celsius pro Jahrhundert entspricht. In einem rationalen wissenschaftlichen Diskurs würden diejenigen, die sich für extreme Maßnahmen zur Verhinderung der globalen Erwärmung ausgesprochen hatten, nun ihre Hypothesen zurückziehen und ruhig überdenken. Dies ist jedoch kein rationaler wissenschaftlicher Diskurs. Auf der Seite der Fragesteller ist es rational: Auf der Seite der Gläubigen geht es um einen zunehmend blinden Glauben. Der neue Aberglaube ist kein fides quaerens intellectum.

Wichtige Fakten über die globale Temperatur

Diese Fakten sollten jedem gezeigt werden, der nach wie vor glaubt, dass die globale Erwärmung real, künstlich und gefährlich ist", wie Obamas Twitteratus sagt.

- Der RSS-Satellitendatensatz zeigt 225 Monate lang von Februar 1997 bis Oktober 2015 überhaupt keine globale Erwärmung - mehr als die Hälfte des 442-monatigen Satellitenrekords.

- Es gab keine Erwärmung, obwohl ein Drittel aller anthropogenen Verhaftungen seit 1750 seit Beginn der Pause im Februar 1997 stattgefunden haben.

- Der gesamte RSS-Datensatz für die 442 Monate Dezember 1978 bis September 2015 zeigt die globale Erwärmung mit einer alarmfreien Rate von nur 1,13 Cº pro Jahrhundert.

- Seit 1950, als ein menschlicher Einfluss auf die globale Temperatur erstmals theoretisch möglich wurde, entspricht der Trend zur globalen Erwärmung weniger als 1,2 Cº pro Jahrhundert.

- Der Trend zur globalen Erwärmung seit 1900 entspricht 0,75 Cº pro Jahrhundert. Dies liegt weit unter der natürlichen Variabilität und hat vielleicht nicht viel mit uns zu tun.

- Die schnellste Erwärmungsrate, die seit 1950 15 Jahre oder mehr dauerte, trat in den 33 Jahren von 1974 bis 2006 auf. Es entsprach 2,0 Cº pro Jahrhundert.

- Vergleichen Sie die Erwärmung auf dem Temperaturdatensatz Mittelenglands in den 40 Jahren 1694-1733, lange vor der industriellen Revolution, was 4,33 C°/Jahrhundert entspricht.

- 1990 entsprach die mittelfristige Vorhersage des IPCC über die kurzfristige Erwärmung 2,8 Cº pro Jahrhundert und lag damit um zwei Drittel über seiner aktuellen Vorhersage von 1,7 Cº pro Jahrhundert.

- Der Erwärmungstrend seit 1990, als der IPCC seinen ersten Bericht verfasst hat, entspricht 1 Cº pro Jahrhundert. Der IPCC hatte fast dreimal so viel vorhergesagt.

- Um der zentralen Prognose des IPCC von 1990-2025 von 1 C° Erwärmung gerecht zu werden, müsste im nächsten Jahrzehnt eine Erwärmung von 0,75 C°, entsprechend 7,5 C°/Jahrhundert, erfolgen.

- Obwohl der IPCC seine kurzfristige Erwärmungsprognose reduziert hat, hat er sein High-End-Geschäft nicht wie üblich reduziert, nämlich die hundertjährige Erwärmungsprognose von 4,8 Cº Erwärmung auf 2100.

- Die vom IPCC prognostizierte Erwärmung um 4,8 Cº bis 2100 ist weit mehr als doppelt so hoch wie die höchste Erwärmungsrate von mehr als 15 Jahren, die seit 1950 gemessen wurde.

- Die 4,8 Cº-by-2100-Vorhersage des IPCC ist viermal so hoch wie der beobachtete reale Erwärmungstrend, da wir theoretisch 1950 begonnen haben könnten, ihn zu beeinflussen.

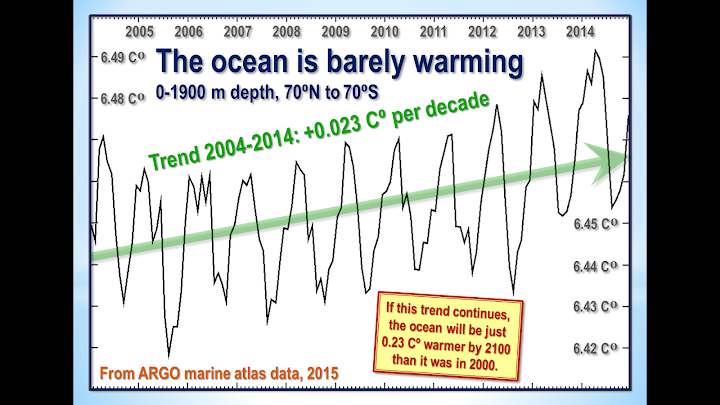

- Die Ozeane erwärmen sich nach Angaben der 3600+ ARGO-Bojen mit einer Rate von nur 0,02 Cº pro Jahrzehnt, was 0,23 Cº pro Jahrhundert oder 1 C° in 430 Jahren entspricht.

- Die jüngsten extremen Wetterereignisse können nicht der globalen Erwärmung zugeschrieben werden, da es keine globale Erwärmung gegeben hat, von der man sprechen könnte. So einfach ist das.

Technischer Hinweis

Unsere neueste aktuelle Grafik zeigt den linearen Regressionstrend der kleinsten Quadrate auf dem monatlichen globalen mittleren Niedrigtroposphären-Datensatz des RSS-Satelliten, so weit zurück, wie es möglich ist, zu gehen und dennoch einen Nulltrend zu finden. Das Startdatum ist nicht "kirschgepflückt", so dass es mit dem Temperaturanstieg durch den el Niño 1998 übereinstimmt. Stattdessen wird er so berechnet, dass er den längsten Zeitraum mit einem Nulltrend findet.

Die Tatsache einer langen Pause ist ein Hinweis auf die zunehmende Diskrepanz zwischen Vorhersage und Realität in der Temperaturaufzeichnung.

Die Satellitendatensätze sind wohl weniger unzuverlässig als andere Datensätze, da sie das Great El Niño 1998 deutlicher darstellen als alle anderen Datensätze. Der Große el Niño, wie seine beiden Vorgänger in den letzten 300 Jahren, verursachte eine weit verbreitete globale Korallenbleiche und liefert einen unabhängigen Beweis dafür, dass die Satellitendatensätze in der Lage sind, solche Schwankungen besser als der Rest zu erfassen, ohne sie künstlich herauszufiltern.

Die Erdtemperaturen werden mit Thermometern gemessen. Thermometer, die in ländlichen Gebieten außerhalb von künstlichen Wärmequellen richtig platziert sind, zeigen Erwärmungsraten unter denen, die veröffentlicht werden. Die Satellitendatensätze basieren auf Referenzmessungen der genauesten verfügbaren Thermometer - Platin-Widerstandsthermometer, die eine unabhängige Überprüfung der Temperaturmessungen durch Überprüfung der bekannten Temperatur der kosmischen Hintergrundstrahlung, die 1% des Gefrierpunktes von Wasser oder nur 2,73 Grad über dem absoluten Nullpunkt beträgt, über Raumspiegelung ermöglichen. Durch die Messung winziger Variationen der kosmischen Hintergrundstrahlung bestimmte die Anisotropiesonde der NASA das Alter des Universums: 13,82 Milliarden Jahre.

Die RSS-Grafik (Abb. 1) ist genau. Die Daten werden monatlich direkt von der RSS-Website erhoben. Ein Computeralgorithmus liest sie aus der Textdatei aus und zeichnet sie automatisch mit einer erweiterten Routine auf, die das Seitenverhältnis des Datenfensters an beiden Achsen automatisch anpasst, um die Daten aus Gründen der Übersichtlichkeit im maximalen Maßstab darzustellen.

Der neueste monatliche Datenpunkt wird visuell auf seine korrekte Position überprüft. Die hellblaue Trendlinie, die über die dunkelblaue Spline-Kurve aufgetragen wird, die die Ist-Daten zeigt, wird durch das Verfahren der linearen Regression der kleinsten Quadrate bestimmt, die den y-Absturz und die Steigung der Linie berechnet.

Das IPCC und die meisten anderen Behörden verwenden die lineare Regression, um globale Temperaturtrends zu bestimmen. Professor Phil Jones von der University of East Anglia empfiehlt es in einer der Climategate-E-Mails. Das Verfahren ist angemessen, da die globalen Temperaturaufzeichnungen wenig Auto-Regression aufweisen, da die Sommertemperaturen in einer Hemisphäre durch den Winter in der anderen kompensiert werden. Daher würde ein AR(n)-Modell Ergebnisse liefern, die sich kaum von einem Trend der kleinsten Quadrate unterscheiden.

Dr. Stephen Farish, Professor für Epidemiologische Statistik an der University of Melbourne, bestätigte freundlicherweise die Zuverlässigkeit des Algorithmus, der den Trend in der Grafik bestimmt, und des Korrelationskoeffizienten, der sehr niedrig ist, da die Daten zwar sehr variabel sind, der Trend aber flach ist.

RSS selbst interessiert sich nun ernsthaft für die Länge der Großen Pause. Dr. Carl Mears, Senior Research Scientist bei RSS, diskutiert es unter remss.com/blog/recent-slowing-rise-global-temperatures.

Die Ergebnisse von Dr. Mears sind in Abb. T1 zusammengefasst:

Abbildung T1. Ausgabe von 33 IPCC-Modellen (türkis) im Vergleich zu gemessenen RSS Global Temperature Change (schwarz), 1979-2014. Es werden die vorübergehenden Abkühlungen durch die Vulkanausbrüche von Chichón (1983) und Pinatubo (1991) gezeigt, ebenso wie die Erwärmungsspitze durch den großen el Niño von 1998.

Dr. Mears schreibt:

"Die Verleugner gehen gerne davon aus, dass die Ursache für die Modell-/Beobachtungsdiskrepanz ein Problem mit der grundlegenden Modellphysik ist, und sie pooh-pooh jede andere Art von Erklärung. Dies lässt sie zu dem Schluss kommen, dass die langfristige Empfindlichkeit des Klimas viel geringer ist, als derzeit angenommen wird."

Dr. Mears räumt die wachsende Diskrepanz zwischen den RSS-Daten und den Modellen ein, behauptet aber, dass das Startdatum für den Global-Temperatur-Diagramm "cherry-picking" sei:

"In jüngster Zeit haben eine Reihe von Artikeln in der Mainstream-Presse darauf hingewiesen, dass es in den letzten zwei Jahrzehnten offenbar kaum oder gar keine Veränderung der globalen Durchschnittstemperatur gegeben hat. Aus diesem Grund bekommen wir viele Fragen nach dem Motto: "Ich habe diese Handlung auf einer denialistischen Website gesehen. Sind das wirklich deine Daten? Während einige dieser Berichte ihre Endpunkte "ausgewählt" haben, um ihre Beweise noch stärker erscheinen zu lassen, besteht kein Zweifel daran, dass die Erwärmungsrate seit Ende der 90er Jahre niedriger ist als die, die von den meisten IPCC AR5-Simulationen des historischen Klimas vorhergesagt wurde. .... Die Denialisten passen sich gerne den Trends ab 1997 an, so dass das große ENSO-Event 1997-98 am Anfang ihrer Zeitreihe steht, was zu einer linearen Anpassung mit der kleinstmöglichen Steigung führt..."

Tatsächlich wird der durch den Großen el Niño von 1998 verursachte Temperaturanstieg in der linearen Trendberechnung fast vollständig durch zwei Faktoren ausgeglichen: den nicht ungleichen Anstieg des El Niño von 2010 und die schiere Länge der Großen Pause selbst. Die Schlagzeilengrafik in diesen Monatsberichten beginnt 1997, denn das ist so weit zurück, dass man in die Daten gehen und dennoch einen Nulltrend erhalten kann.

Abb. T1a. Grafiken für RSS- und GISS-Temperaturen ab 1997 und 2001. Für jeden Datensatz sind die Trendlinien nahezu identisch, was eindeutig zeigt, dass das Argument, dass die Pause durch den el Nino 1998 verursacht wurde, falsch ist (Werner Brozek und Professor Brown haben diese ordentliche Demonstration ausgearbeitet).

Seltsamerweise zieht Dr. Mears die terrestrischen Datensätze den Satellitendatensätzen vor. Das UK Met Office verwendet die Satellitendaten jedoch, um seinen eigenen terrestrischen Datensatz zu kalibrieren.

Die Länge der Pause, so bedeutsam sie auch jetzt ist, ist von geringerer Bedeutung als die ständig wachsende Diskrepanz zwischen den von den Modellen vorhergesagten Temperaturtrends und der weitaus weniger aufregenden realen Temperaturänderung, die beobachtet wurde.

Quellen der IPCC-Projektionen in den Abbildungen 2 und 3

Der erste Bewertungsbericht des IPCC prognostizierte, dass die globale Temperatur bis 2025 um 1,0[0,7, 1,5] Cº steigen würde, was 2,8[1,9, 4,2] Cº pro Jahrhundert entspricht. Die Zusammenfassung fragte: "Wie viel Vertrauen haben wir in unsere Prognosen?" Der IPCC wies auf einige Unsicherheiten hin (Wolken, Ozeane usw.), schloss aber:

"Dennoch haben wir große Zuversicht, dass Modelle zumindest die breit angelegten Merkmale des Klimawandels vorhersagen können. .... Es gibt Ähnlichkeiten zwischen den Ergebnissen der gekoppelten Modelle mit einfachen Darstellungen des Ozeans und denen mit komplexeren Beschreibungen, und unser Verständnis der auftretenden Unterschiede gibt uns ein gewisses Vertrauen in die Ergebnisse."

Dieses "substantielle Vertrauen" war ein erhebliches Übervertrauen. Denn die Rate der globalen Erwärmung seit 1990 - das wichtigste der "breit angelegten Merkmale des Klimawandels", die die Modelle vorhersagen sollten - liegt heute unter der Hälfte dessen, was der IPCC damals vorhergesagt hatte.

Im Jahr 1990 sagte der IPCC dies:

"Basierend auf aktuellen Modellen, die wir vorhersagen.

"unter den IPCC Business-as-Usual (Szenario A) Treibhausgasemissionen ist eine Steigerungsrate der globalen Mitteltemperatur im nächsten Jahrhundert von etwa 0,3 Cº pro Jahrzehnt (mit einem Unsicherheitsbereich von 0,2 Cº bis 0,5 Cº pro Jahrzehnt) höher als in den letzten 10.000 Jahren. Dies wird zu einem wahrscheinlichen Anstieg der globalen Mitteltemperatur um etwa 1 Cº über den aktuellen Wert bis 2025 und um 3 Cº vor dem Ende des nächsten Jahrhunderts führen. Der Anstieg wird aufgrund des Einflusses anderer Faktoren nicht konstant sein" (S. xii).

Später sagte der IPCC:

"Die unten aufgeführten Zahlen basieren auf hochauflösenden Modellen, die so skaliert sind, dass sie mit unserer besten Schätzung der globalen mittleren Erwärmung von 1,8 Cº bis 2030 übereinstimmen. Für Werte, die mit anderen Schätzungen des globalen Temperaturanstiegs übereinstimmen, sollten die folgenden Zahlen für den niedrigen Schätzwert um 30% reduziert oder für den hohen Schätzwert um 50% erhöht werden" (S. xxiv).

Die orangefarbene Region in Abb. 2 stellt das mittelfristige Szenario des IPCC dar - eine Schätzung der kurzfristigen Erwärmung, d.h. 1,0[0,7, 1,5] K bis 2025.

Die vom IPCC prognostizierte globale Erwärmung in den 25 Jahren von 1990 bis heute unterscheidet sich kaum von einer geraden Linie (Abb. T2).

Abbildung T2. Historische Erwärmung von 1850-1990 und prognostizierte Erwärmung von 1990-2100 auf dem "Business-as-usual"-Szenario A (IPCC, 1990, S. xxii) des IPCC.

Da dieser Unterschied zwischen einer geraden Linie und dem leichten Anstieg der Erwärmungsrate, den das IPCC im Zeitraum 1990-2025 vorhergesagt hat, so gering ist, kann man ihn anders betrachten. Um die 1 K zentrale Schätzung der Erwärmung seit 1990 bis 2025 zu erreichen, müsste in den nächsten zehn Jahren doppelt so viel Erwärmung stattfinden wie in den letzten 25 Jahren. Das ist unwahrscheinlich.

Aber ist die Pause vielleicht darauf zurückzuführen, dass die CO2-Emissionen nicht so schnell gestiegen sind wie die "Business-as-usual"-Szenario-A-Prognose des IPCC aus dem Jahr 1990? Nein: Die CO2-Emissionen sind etwas über die Szenario-A-Prognose gestiegen (Abb. T3).

Abbildung T3. CO2-Emissionen aus fossilen Brennstoffen usw. im Jahr 2012, von Le Quéré et al. (2014), dargestellt anhand der Grafik der "vom Menschen verursachten Kohlendioxidemissionen", in Milliarden Tonnen Kohlenstoff pro Jahr, vom IPCC (1990).

Die CO2-Emissionen seit 1990 haben sich daher als näher am Szenario A wie kein anderer Fall erwiesen, denn bei aller Diskussion über die CO2-Emissionsreduzierung ist es Tatsache, dass der Expansionsgrad der Verbrennung fossiler Brennstoffe in China, Indien, Indonesien, Brasilien usw. die bisher im Westen erreichten dürftigen Reduzierungen bei weitem übersteigt.

Zwar ist die Methankonzentration nicht gestiegen, wie 1990 prognostiziert (Abb. T4), denn die Methanemissionen steigen zwar weitgehend unkontrolliert, aber einfach nicht, wie von den Modellen vorhergesagt. Auch hier waren alle Vorhersagen extravagant haltlos.

Das Gesamtbild ist klar. Szenario A ist das Emissionsszenario von 1990, das dem beobachteten CO2-Ausstoß am nächsten kommt.

Abbildung T4. Die Methankonzentration, wie sie in vier IPCC-Bewertungsberichten vorhergesagt wurde, zusammen mit dem (in Schwarz) beobachteten Ergebnis, das auf dem Tiefpunkt der geringsten Vorhersage liegt. Diese Grafik erschien im Vorentwurf des IPCC (2013), wurde aber auf mysteriöse Weise aus der endgültigen, veröffentlichten Version gestrichen, weil der IPCC keinen so klaren Vergleich zwischen absurd übertriebenen Vorhersagen und unaufregender Realität darstellen wollte.

Um genau zu sein, ein Vierteljahrhundert nach 1990, beträgt das bisherige Ergebnis der globalen Erwärmung - ausgedrückt als der lineare Regressionstrend mit den kleinsten Quadraten auf dem Mittelwert der monatlichen globalen Oberflächenmitteltemperaturanomalien von RSS und UAH - 0,27 Cº, was etwas mehr als 1 Cº/ Jahrhundert entspricht. Die zentrale Schätzung des IPCC von 0,71 Cº, was 2,8 Cº/Jahrhundert entspricht, die für das Szenario A im IPCC (1990) mit "erheblicher Zuversicht" vorhergesagt wurde, näherte sich dreimal zu groß. Tatsächlich liegt das Ergebnis selbst bei der kleinsten Schätzung deutlich unter dem Wert.

1990 war die zentrale Prognose des IPCC für die kurzfristige Erwärmungsrate um zwei Drittel höher als heute. Dann waren es 2,8 C/Jahrhundert Äquivalente. Jetzt sind es nur noch 1,7 Cº Äquivalent - und, wie Abb. T5 zeigt, erweist sich selbst das als eine erhebliche Übertreibung.

Erwärmt sich der Ozean?

Eine häufig diskutierte Erklärung für die Große Pause ist, dass das gekoppelte Ozean-Atmosphärensystem weiterhin Wärme in etwa der von den Modellen vorhergesagten Geschwindigkeit angesammelt hat, dass aber in den letzten Jahrzehnten die Wärme durch den Ozean aus der Atmosphäre abgeführt wurde, und da sich die oberflächennahen Schichten weltweit weitaus weniger erwärmen als die Modelle vorhergesagt hatten, wird angenommen, dass die so genannte "fehlende Wärme" in die wenig gemessenen Abgrundschichten unter 2000 m geflossen ist, aus denen sie irgendwann hervorgehen kann.

Ob sich der Ozean erwärmt, ist eigentlich nicht bekannt: Jede der 3600 automatisierten ARGO-Bathythermographenbojen misst monatlich nur drei Messungen in 200.000 Kubikkilometern Ozean - etwa eine 100.000 Quadratkilometer große Box mit mehr als 316 Quadratkilometern und 2 km Tiefe. Die Ergebnisse auf der Grundlage einer Lösung, die spärlich ist (was, wie Willis Eschenbach sagt, ungefähr dem Versuch entspricht, ein einziges Temperatur- und Salzgehaltsprofil an einem einzigen Punkt im Lake Superior weniger als einmal im Jahr zu nehmen), werden nicht viel besser sein als Rätselraten.

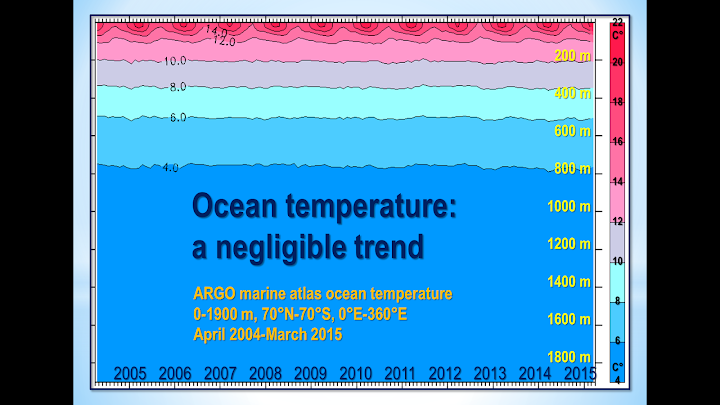

Leider scheint ARGO den Ozeandatensatz seit Dezember 2014 nicht mehr aktualisiert zu haben. Was wir jedoch haben, gibt uns 11 volle Jahre an Daten. Die Ergebnisse sind in Abb. T5 dargestellt. Die Erwärmung des Ozeans, wenn ARGO Recht hat, entspricht nur 0,02 Cº decade-1, was 0,2 Cº century-1 entspricht.

Abbildung T5. Der gesamte, fast globale ARGO 2 km lange Ozeantemperaturdatensatz von Januar 2004 bis Dezember 2014 (schwarze Spline-Kurve), wobei der lineare Regressionstrend der kleinsten Quadrate aus den Daten des Autors berechnet wurde (grüner Pfeil).

Schließlich, obwohl die ARGO-Bojen die Temperaturänderung des Ozeans direkt messen, wandelt NOAA vor der Veröffentlichung die Temperaturänderung craftily in Zettajoules der Änderung des Meereswärmegehalts um, was die Änderung viel größer erscheinen lässt.

Die erschreckend klingende Wärmegehaltsänderung von 260 ZJ von 1970 bis 2014 (Abb. T6) entspricht nur 0,2 K/Jahrhundert der globalen Erwärmung. Alle jene "Hiroshima-Hitzebomben", von denen die klimaextremen Websites sprechen, sind ein kaum wahrnehmbarer Nadelstich. Der Ozean und seine Wärmekapazität sind viel größer, als einige vielleicht denken.

Bild T6. Ozeanwärme ändert sich 1957-2013 in Zettajoules vom NOAA NODC Ocean Climate Lab: http://www.nodc.noaa.gov/OC5/3M_HEAT_CONTENT, wobei die Wärmegehaltswerte in die ursprünglich gemessenen Meerestemperaturänderungen in Kelvin zurückgerechnet werden. Die Umwandlung der winzigen Erwärmungsdaten durch die NOAA in Zettajoules, kombiniert mit dem übertriebenen vertikalen Aspekt der Grafik, hat den Effekt, dass eine sehr kleine Änderung der Meerestemperatur wesentlich signifikanter erscheint als sie ist.

Die Umwandlung der Änderung des Meereswärmegehalts zurück in die Temperaturänderung zeigt eine interessante Diskrepanz zwischen den Daten der NOAA und denen des ARGO-Systems. Über den Zeitraum der ARGO-Daten, von 2004-2014, deuten die NOAA-Daten darauf hin, dass sich die Ozeane auf 0,05 Cº Dekade -1 erwärmen, was 0,5 Cº Jahrhundert-1 entspricht, oder eher mehr als doppelt so schnell wie ARGO.

ARGO hat den besser aufgelösten Datensatz, aber da die Auflösungen aller Ozeandatensätze sehr niedrig sind, sollte man all diese Ergebnisse mit Vorsicht behandeln.

Was man sagen kann, ist, dass der Unterschied zwischen der zugrunde liegenden Erwärmungsrate des Ozeans und der Atmosphäre statistisch nicht signifikant ist, was darauf hindeutet, dass, wenn sich die "fehlende Wärme" in den Ozeanen versteckt, sie auf magische Weise ihren Weg in die Abgrundschichten gefunden hat, ohne es zu schaffen, die oberen Schichten auf dem Weg zu erwärmen.

Auch bei diesen Daten gibt es keine Hinweise auf eine schnelle oder katastrophale Erwärmung der Ozeane.

Darüber hinaus hat bisher noch keine empirische, theoretische oder numerische Methode, ob komplex oder einfach, mechanisch erfolgreich spezifiziert, entweder wie die durch die anthropogene Treibhausgasanreicherung der Atmosphäre erzeugte Wärme den Tiefsee erreicht hat, ohne den Wärmeinhalt der dazwischen liegenden oberflächennahen Schichten stark zu verändern, oder wie die Wärme vom Meeresboden schließlich wieder auftauchen kann, um die oberflächennahen Klimabedingungen zu stören, die für das Landleben auf der Erde relevant sind.

Abbildung T7. Die nahezu globalen Meerestemperaturen nach Schichten, 0-1900 m, bieten eine visuelle Überprüfung der Realität, um zu zeigen, wie wenig die oberen Schichten von geringfügigen Änderungen der globalen Luftoberflächentemperatur betroffen sind. Quelle: ARGO Marine Atlas.

Update 2019

Da seit dem Erscheinen dieses Artikels 2015 bereits wieder 4 Jahre vergangen sind, habe ich die ARGO Daten etwas detaillierter aktualisiert.

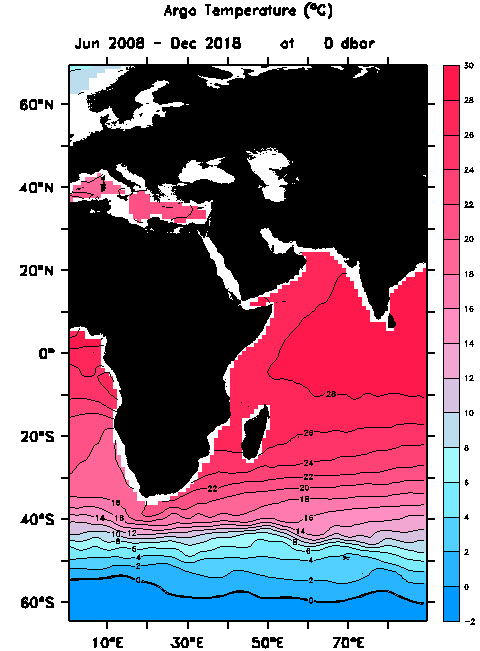

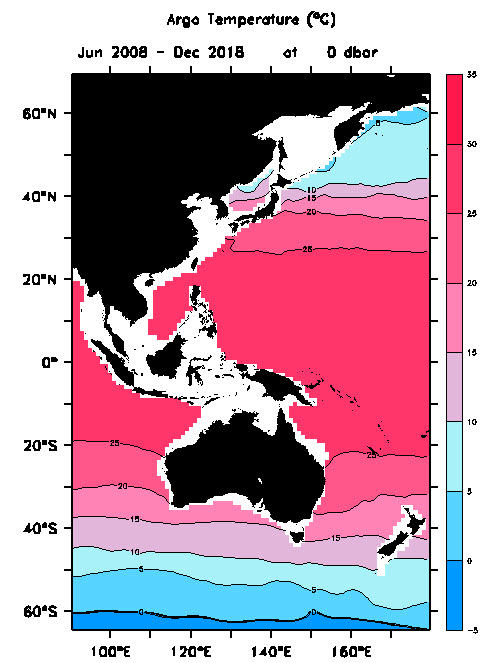

Mittelmeer, Ägäis, das arabische Meer und einen Teil des indischen Ozeans

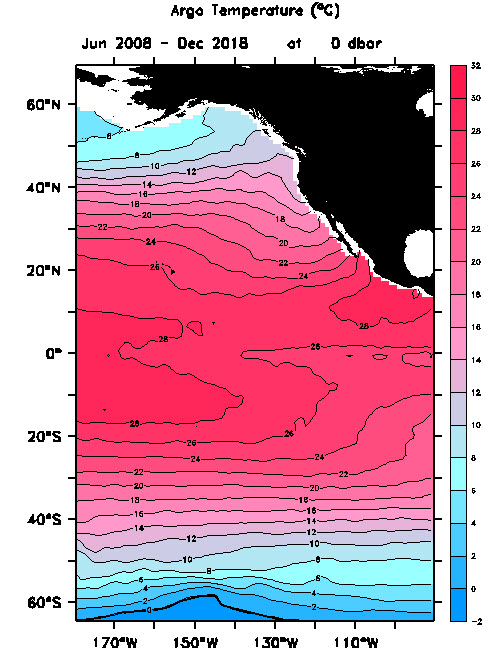

Als erstes der geographische Bereich zwischen 0 - 90 Grad West, was den Mittelmeer, Ägäis, das arabische Meer und einen Teil des indischen Ozeans. Die Temperaturen in Äquatornähe bewegen sich um im Mittel über den gesamten Zeitraum, zwischen 25 und 30 Grad an der Oberfläche.

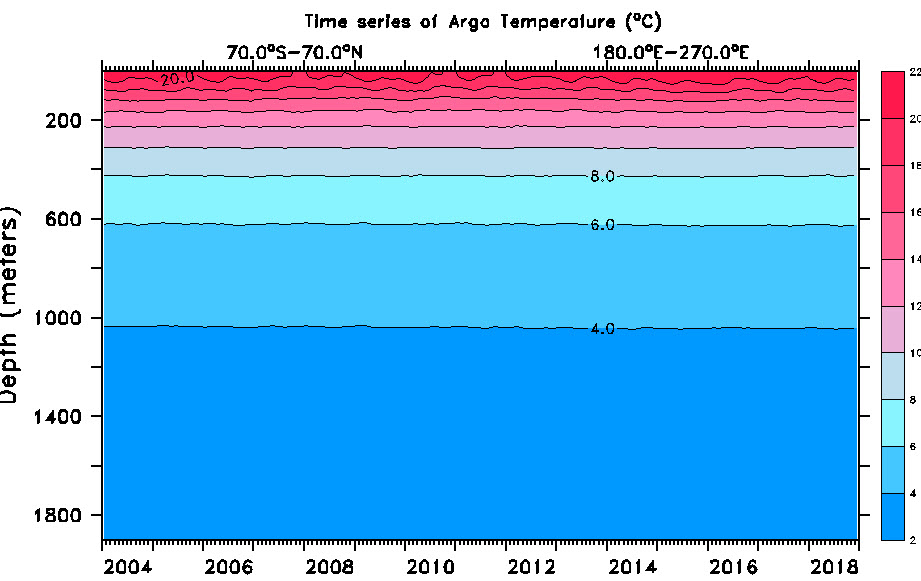

Nun das gleiche Gebiet, allerdings unter Berücksichtigung der Temperaturentwicklung über den gleichen Zeitraum und einer Meerestiefe zwischen 0 bis 1900 Meter.

Die horizontalen Linien zeigen die Temperaturentwicklung über das ganze Gebiet zwischen 70.0°Süd bis 70.0°Nord und 0.0°West bis 90.0°West, zwischen 0 bis 1900 Meter unter Meereshöhe und über den Zeitraum von Januar 2004 bis Dezember 2018.

In den oberen Meeresschichten sind die Jahreswechsel sehr gut durch den wellenförmigen Verlauf zu erkennen. Bei genauerer Betrachtung ist eine leichte Abkühlung zu erkennen. Sehen Sie sich dazu den Temperaturverlauf knapp bei 1200 Meter links, im Vergleich zum rechten Ende an. Das Linienende rechts ist minimal etwas weiter unten, was darauf schliessen lässt, dass sich diese Meere im Lauf der letzten 14 Jahre um ca. 0.2 Grad abkühlten. Diese 0.2 Grad erscheinen im ersten Augenblick als nicht viel, betrachtet man jedoch das gewaltige Volumen über das gesamte Gebiet mit einer Tiefe bis zu 1900 Meter, sind unglaubliche Energiemengen verloren gegangen. Bzw. der natürliche Energieaustausch zwischen solarer Einstrahlung, der Wärmeumwälzung der Ozeane und der Wärmekreislauf zwischen Ozeane und Atmosphäre, sind im Verlauf der letzten 14 Jahre abnehmend. Dieser Trend wiederspricht allen Computersimulationen und Prophezeiungen der letzten 30 Jahre!

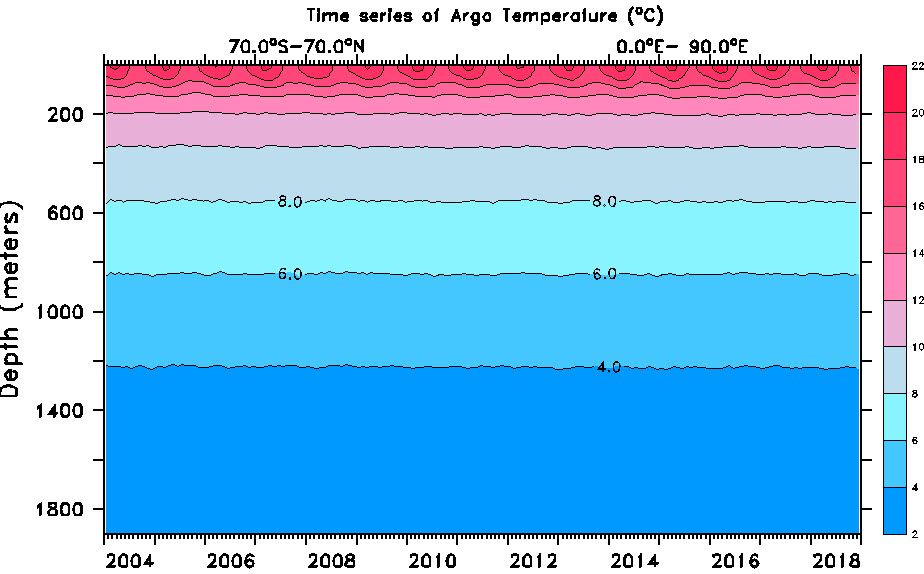

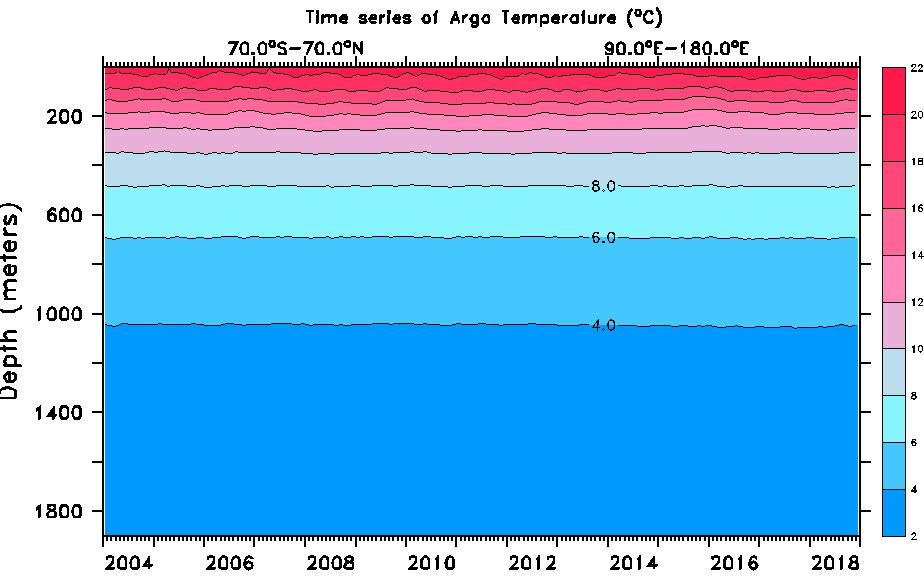

Das Gebiet im indischen Ozean

Im Bild oben sehen Sie in der Mitte Australien und links oben Teile des unteren asiatischen Raums. Das Auswertungsgebiet umfasst 90°West bis 180°West und 70°Nord bis 70°Süd der Meeresoberflächen. Links von Australien der östliche indische Ozean und rechts von Australien der westliche Südpazifik.

Nun zur Temperaturentwicklung über den gleichen Zeitraum vom Januar 2004 bis Dezember 2018 und Meerestiefe zwischen 0 und 1900 Meter.

Auffallend ist hier, dass die Wellenform in den oberen Meeresschichten nicht so ausgeprägt sind, wie im westlichen Teil des indischen Ozeans und dem Mittelmeer. Allerdings ist auch hier eine ganz leichte Abkühlung von ca. 0.2 Grad über den gesamten Zeitraum erkennbar.

Östlicher Südpazifik

Auch im östlichen Südpazifik ist der Temperaturverlauf an der Meeresoberfläche nicht gleichmässig. Allerdings ist in allen Meerestiefen eine noch leicht grössere Abkühlung erkennbar, als im arabischen Meer, dem indischen Ozean und dem westlichen Südpazifik. Hier beträgt die Abkühlung seit Januar 2004 ca. 0.3 Grad Celsius.

Die meisten Ozeanmodelle, die bei der Durchführung gekoppelter Sensitivitätsläufe für allgemeine Zirkulationsmodelle verwendet werden, können die meisten der physikalischen Prozesse, die für die Erfassung der Wärmeaufnahme durch die Tiefsee relevant sind, einfach nicht lösen.

Letztendlich verlangt das zweite Gesetz der Thermodynamik, dass jede Wärme, die sich im tiefen Ozean angesammelt hat, durch verschiedene Diffusionsprozesse abgeführt wird. Es ist nicht plausibel, dass jede Wärme, die von der Tiefsee aufgenommen wird, plötzlich den oberen Ozean und über den oberen Ozean die Atmosphäre erwärmt.

Wäre die Erklärung der "tiefen Hitze" für die Pause richtig gewesen (und es ist nur eines von Dutzenden, die angeboten wurden), hätten die komplexen Modelle dies nicht richtig berücksichtigt: Andernfalls wäre die wachsende Diskrepanz zwischen den vorhergesagten und beobachteten atmosphärischen Erwärmungsraten nicht so signifikant geworden wie bisher.

Anfang Oktober 2015 hat Steven Goddard seiner Website einige sehr interessante Grafiken hinzugefügt. Die Diagramme zeigen, inwieweit der Meeresspiegel manipuliert wurde, um ihn so aussehen zu lassen, als ob der Meeresspiegel gestiegen wäre, obwohl man argumentieren kann, dass es tatsächlich wenig oder gar keinen Anstieg gegeben hat.

Warum wurden die Vorhersagen der Modelle übertrieben?

1990 prognostizierte das IPCC - auf seinem Business-as-usual-Szenario A -, dass es von der industriellen Revolution bis heute 4 Watt pro Quadratmeter Strahlungsleistung durch den Menschen gegeben hätte (Bild T8):

Abbildung T8. Vorausgesagte vom Menschen verursachte Strahlungseinbrüche (IPCC, 1990).

Ab 1995 beschloss das IPCC jedoch, auf der Grundlage eher schlanker Beweise davon auszugehen, dass anthropogene Partikelaerosole - meist Ruß aus der Verbrennung - die Erde weitgehend genug von der Sonne abschirmen, um einen starken negativen Druck auszuüben. Sie hat nun auch verspätet erkannt, dass ihre prognostizierten Steigerungen der Methankonzentration starke Übertreibungen waren. Als Ergebnis dieser und anderer Veränderungen schätzt sie nun, dass der anthropogene Netto-Trieb des Industriezeitalters nur 2,3 Watt pro Quadratmeter beträgt, also etwas mehr als die Hälfte der Prognose von 1990 (Abb. T9):

Abbildung T9: Anthropogene Netto-Forcings, 1750 bis 1950, 1980 und 2012 (IPCC, 2013).

Aber auch das kann eine erhebliche Übertreibung sein. Für die bestmögliche Schätzung des aktuellen aktuellen Top-of-Atmosphäre strahlungsbedingten Ungleichgewichts (total natural and anthropo-genic net forcing) beträgt es nur 0,6 Watt pro Quadratmeter (Abb. T10):

Abbildung T10. Energie-Budgetdiagramm für die Erde von Stephens et al. (2012)

Kurz gesagt, der größte Teil des vom IPCC vorhergesagten Zwangs ist entweder eine Übertreibung oder hat bereits zu einer Temperaturänderung geführt, die er verursachen würde. Es gibt wenig globale Erwärmung in der Pipeline als Folge unserer vergangenen und gegenwärtigen Sünden der Emissionen.

Es ist auch möglich, dass das IPCC und die Modelle die Klimasensitivität unerbittlich übertrieben haben. Ein aktuelles Papier zu dieser Frage ist Monckton von Brenchley et al. (2015), das eine Klimasensitivität von etwa 1 Cº pro CO2-Verdopplung ergab (gehen Sie zu scibull.com und klicken Sie auf "Most Read Articles"). Das Papier identifizierte Fehler in der Behandlung von Temperaturrückkopplungen und deren Verstärkung, die zwei Drittel der vom IPCC vorhergesagten Gleichgewichtserwärmung ausmachen.

Professor Ray Bates hielt im Sommer 2015 in Moskau ein Papier, in dem er auf der Grundlage der Analyse von Lindzen & Choi (2009, 2011) (Abb. T10) zu dem Schluss kam, dass Temperaturrückwirkungen netto-negativ sind. Dementsprechend unterstützt er die Schlussfolgerung sowohl von Lindzen & Choi (1990) (Abb. T11) als auch von Spencer & Braswell (2010, 2011), dass die Klimasensitivität unter - und vielleicht deutlich unter - 1 Cº pro CO2-Verdopplung liegt.

Abbildung T11. Realität (Mitte) vs. 11 Modelle. Von Lindzen & Choi (2009).

Eine wachsende Anzahl von überprüften Papieren findet eine Klimasensitivität deutlich unter der 3[1,5, 4,5] Cº pro CO2-Verdopplung, die erstmals im Charney-Bericht von 1979 für die U.S. National Academy of Sciences vorgeschlagen wurde, und ist auch heute noch die beste Schätzung des IPCC.

Nach den bisherigen Erkenntnissen gibt es daher keine wissenschaftliche Grundlage, um überhaupt Maßnahmen zur Minderung der CO2-Emissionen zu ergreifen.